Apple تحارب الاعتداء الجنسى على الأطفال

عندما أعلنت Apple عن وضع تغييرات تخطط لإدخالها على أجهزة iOS فى محاولة للمساعدة فى الحد من إساءة معاملة الأطفال من خلال العثور على مواد الاعتداء الجنسى على الأطفال (CSAM)، ولدت أجزاء من خطتها ردود فعل عنيفة.

ومنها وفقا لما نشره موقع " the verege " التقنى، أولاً، يتم طرح تحديث لتطبيق البحث والمساعد الصوتى Siri على iOS 15 و watchOS 8 و iPadOS 15 و macOS Monterey، عندما يبحث المستخدم عن مواضيع تتعلق بالاعتداء الجنسى على الأطفال، ستعيد Apple توجيه المستخدم إلى موارد للإبلاغ عن CSAM ، أو الحصول على مساعدة لجذب هذا المحتوى.

ولكن خطتى CSAM الأخريين من Apple هما اللتان قوبلتا بالنقد، وسيضيف أحد التحديثات خيار الرقابة الأبوية إلى الرسائل، ويرسل تنبيها إلى الوالدين إذا كان طفل يبلغ من العمر 12 عاما أو أصغر يشاهد أو يرسل صورا جنسية صريحة، ويحجب الصور لأى مستخدمين أقل من 18 عامًا.

والأمر الأكثر إثارة للجدل هو خطة Apple لمسح الصور الموجودة على الجهاز للعثور على CSAM قبل تحميلها على iCloud ، وإبلاغ المشرفين فى Apple بها والذين يمكنهم بعد ذلك تحويل الصور إلى المركز الوطنى للأطفال المفقودين والمستغلين (NCMEC) فى حالة وجود تطابق محتمل، وبينما تقول Apple إن الميزة ستحمي المستخدمين مع السماح للشركة بالعثور على محتوى غير قانونى، ويقول العديد من منتقدى Apple والمدافعين عن الخصوصية إن هذا الحكم هو فى الأساس باب خلفى أمنى، وهو تناقض واضح مع التزام Apple المعلن منذ فترة طويلة بخصوصية المستخدم.

اقرأ أيضاً

آبل تدخل المنافسة فى مجال المشاهدة الجماعية بخاصية SharePlay

آبل تدخل المنافسة فى مجال المشاهدة الجماعية بخاصية SharePlay ”آبل” تخطط دعم أجهزة ”Mac” القادمة بتقنية التعرف على الوجه

”آبل” تخطط دعم أجهزة ”Mac” القادمة بتقنية التعرف على الوجه ”فيسبوك” يتيح خدمة الألعاب السحابية بأجهزة ”آبل”

”فيسبوك” يتيح خدمة الألعاب السحابية بأجهزة ”آبل” ”آبل” تطرح خدمة الدفع بالتقسيط على منتجاتها قريبا

”آبل” تطرح خدمة الدفع بالتقسيط على منتجاتها قريبا آبل تطلق مجموعة بطاريات MagSafe لأجهزة آيفون 12

آبل تطلق مجموعة بطاريات MagSafe لأجهزة آيفون 12 صراع جديد بين مايكروسوفت وآبل

صراع جديد بين مايكروسوفت وآبل سرقة ملفات خطيرة من ”آبل” والهاكرز يهددون بفضح أسرار تزلزل العالم

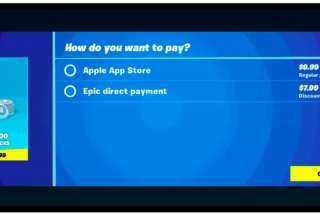

سرقة ملفات خطيرة من ”آبل” والهاكرز يهددون بفضح أسرار تزلزل العالم آبل تحذف لعبة Fortnite من متجر التطبيقات (Apple store)

آبل تحذف لعبة Fortnite من متجر التطبيقات (Apple store) تعرف على موعد الإعلان عن آيفون 12 من آبل

تعرف على موعد الإعلان عن آيفون 12 من آبل جوجل تطالب موظفيها بالعمل من المنزل تجنبا لـ”كورونا” وآبل تحذو حذوها

جوجل تطالب موظفيها بالعمل من المنزل تجنبا لـ”كورونا” وآبل تحذو حذوها آبل" تدفع المال لمراهق اكتشف خللا أمنيا كبيرا في أحد تطبيقاتها

آبل" تدفع المال لمراهق اكتشف خللا أمنيا كبيرا في أحد تطبيقاتها كيف توقف تتبع "آبل" و"جوجل" لتحركاتك

كيف توقف تتبع "آبل" و"جوجل" لتحركاتك